本文为原创内容,未经授权禁止转载

揭秘 AI 大模型背后的硬件设备:2024 年新态势 在人工智能飞速发展的当下,AI 大模型成为了众人瞩目的焦点。但很多人不知道,支撑这些强大模型运行的硬件设备究竟是什么。今天,就让我们深入了解一番。

核心处理器:GPU 与 TPU

说起 AI 大模型硬件,GPU(图形处理器)绝对是“明星选手”。英伟达的 GPU 在 AI 领域占据着主导地位。以 OpenAI 训练模型为例,大量的英伟达 GPU 并行工作,为复杂的神经网络训练提供强大算力。谷歌推出的 TPU(张量处理单元)也不容小觑,它是专门为机器学习定制的芯片。在谷歌自家的一些大型语言模型训练中,TPU 发挥了关键作用,其针对张量运算的优化,大幅提升了训练效率。

存储设备:大容量与高速度

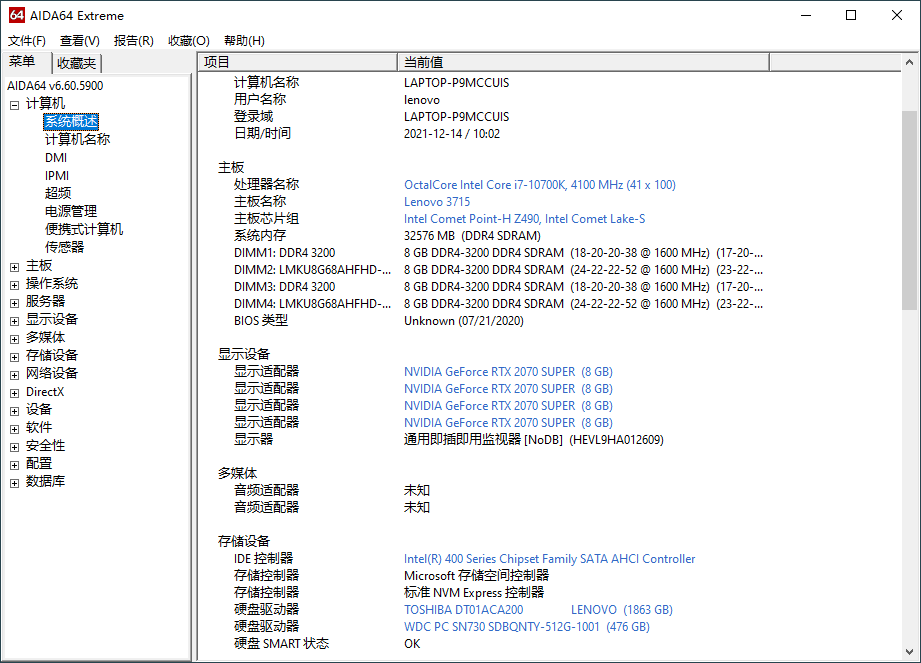

AI 大模型训练需要处理海量的数据,这就对存储设备提出了极高要求。传统的硬盘可能难以满足需求,SSD(固态硬盘)凭借其快速的读写速度成为了更优选择。像一些科研机构在训练医学影像分析的 AI 大模型时,需要频繁读取大量的医学影像数据,SSD 可以保证数据读取的及时性,让模型训练更加顺畅。同时,大容量的存储也必不可少,以容纳模型训练过程中产生的各种参数和中间数据。

网络设备:保障数据流通

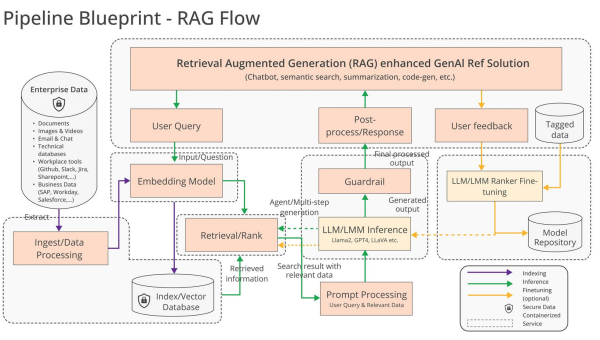

AI 大模型训练往往不是一台设备就能完成的,而是多台设备协同工作。这时候,高速稳定的网络设备就显得尤为重要。高速以太网交换机可以确保设备之间的数据快速传输,减少通信延迟。在分布式训练场景中,如果网络出现卡顿,会严重影响训练的效率和效果。比如,一家科技公司在分布式训练大型语音识别模型时,升级了网络设备后,训练时间明显缩短。

未来趋势:定制化与融合

随着 AI 大模型的不断发展,硬件设备也在朝着定制化和融合的方向前进。越来越多的企业和研究机构开始研发针对特定模型或应用场景的专用硬件。同时,不同类型的硬件设备也在相互融合,以提供更强大的整体性能。

未来,AI 大模型硬件设备还将不断创新,为人工智能的发展提供更坚实的支撑。我们可以期待,在这些硬件的助力下,AI 大模型会给我们带来更多惊喜。

本文为原创内容,未经授权禁止转载

暂无评论内容