AI文本模型运行,显卡是必需品吗?——2025年AI写作趋势下的深度探讨

本文为原创内容,未经授权禁止转载

在2025年的今天,AI文本模型的发展可谓日新月异。不少写作爱好者和专业人士都开始好奇,运行这些AI文本模型,显卡到底是不是必需品呢?

咱先来说说AI文本模型的运行原理。简单来讲,AI文本模型在处理大量文本数据、进行复杂的计算时,需要强大的算力支持。就好比我一朋友,他自己搭建了一个小型的AI写诗模型。一开始,他用普通电脑CPU来运行,结果那速度,慢得像蜗牛爬。一首简单的五言绝句,都得等老半天才能生成。

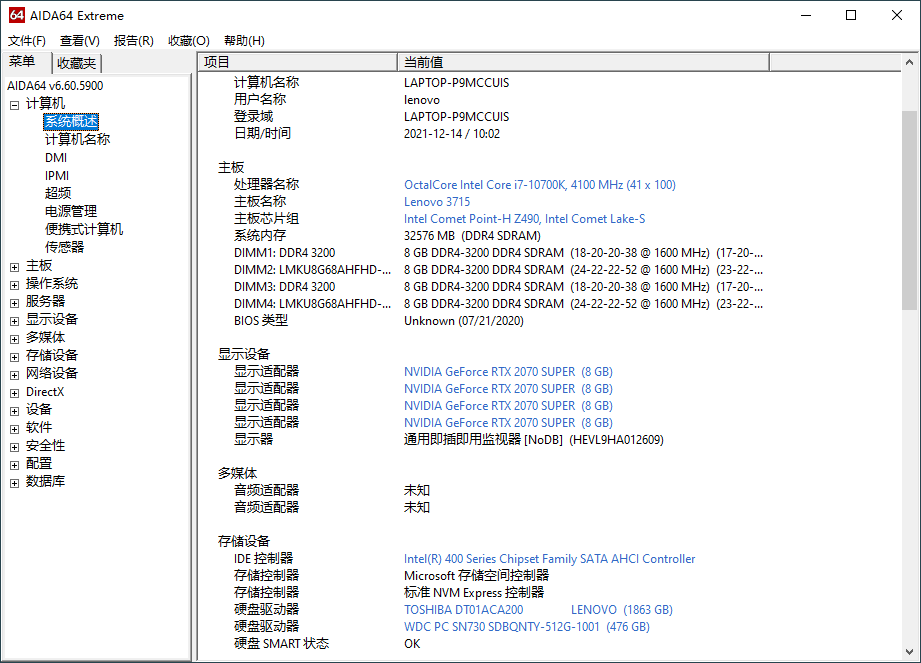

这时候,显卡的优势就体现出来了。显卡,尤其是专门用于深度学习的GPU,拥有大量的计算核心。根据相关行业报告显示,在一些复杂的AI文本训练任务中,GPU的计算速度能比普通CPU快数十倍甚至上百倍。这就好比把拉货的小毛驴换成了大卡车,效率直接起飞。

不过呢,也不是所有的AI文本模型都一定得要显卡。对于一些简单的、数据量较小的模型,或者只是进行简单的推理任务,普通的CPU也能勉强应付。就像写个几百字的小短文,用普通电脑也能完成,虽然可能慢点,但也能出结果。

从2025年AI写作趋势来看,随着模型的不断升级和对生成质量要求的提高,显卡的重要性会越来越凸显。那些追求高效、高质量输出的用户,配备一块性能强劲的显卡几乎是必然选择。但要是你只是偶尔玩玩简单的AI文本生成,那也不一定非得去买个昂贵的显卡。

所以,AI文本模型需不需要显卡,还得看具体的使用场景和需求。大家可以根据自己的情况来决定是否要在显卡上投资。

本文为原创内容,未经授权禁止转载

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容